以下文章来源于上堵吟 ,作者一路到底孟子敬

▼

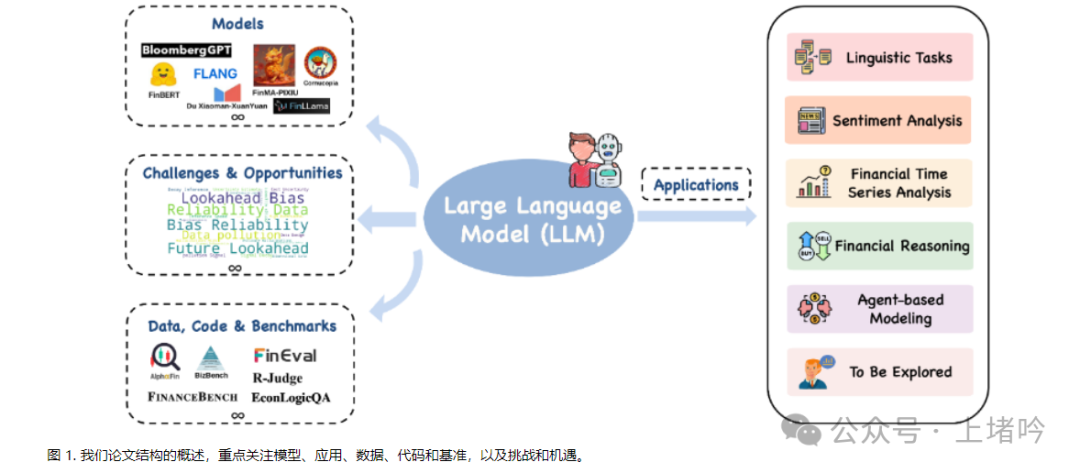

金融领域一直以来都以其复杂性、不确定性和快速演变而著称。随着技术的发展,先进计算模型在金融领域的应用获得了显著的发展动力。在这些进步中,大语言模型(LLM)已成为一个强大的工具,在理解上下文、处理海量数据以及生成类人文本方面表现出色。将LLM应用于金融领域有望改变传统实践,推动创新,并在各种金融任务中开创新的机遇。

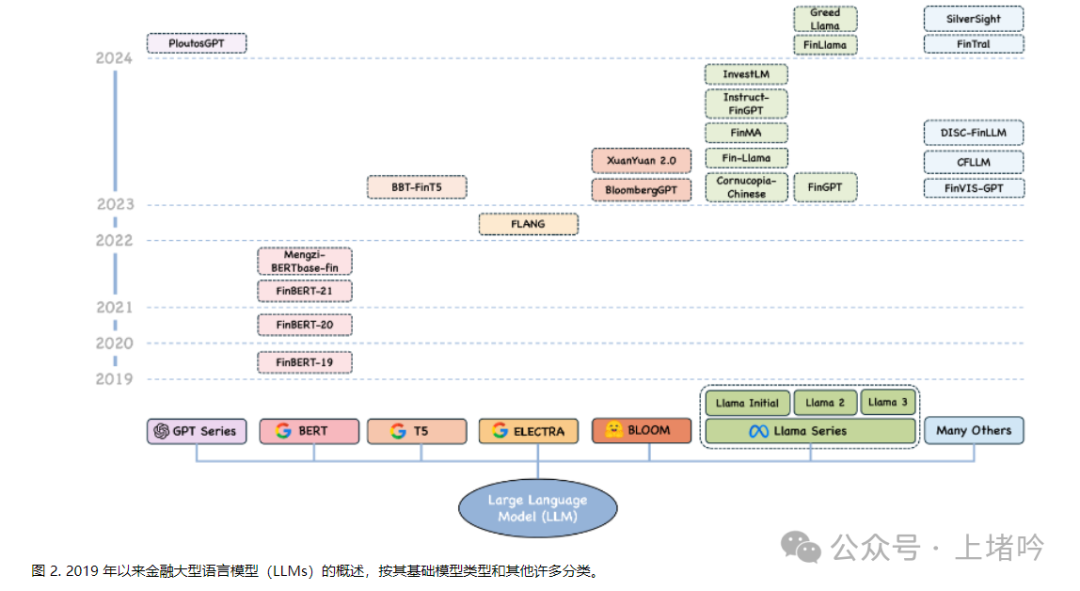

LLM(如GPT系列、BERT及其金融特定变体FinBERT)在自然语言处理(NLP)任务中表现出色。这些模型利用复杂的算法和在海量数据集上的广泛预训练来实现高级上下文理解、定制能力和实时分析的可扩展性。它们检测复杂情绪状态和提供准确解释的能力使其在金融领域尤为宝贵,因为理解市场情绪并做出明智决策至关重要。

近年来,金融领域越来越多地将LLM应用于各种场景。这些应用不仅重塑了金融分析的格局,也为市场行为和经济活动提供了新的视角。例如,在语言任务中,LLM擅长总结和提取海量金融文件中的关键信息,从而将复杂的金融叙事简化为简明扼要的摘要,实现更高效的信息处理。情感分析作为金融领域最关键的应用之一,几十年来一直备受关注。LLM的进步使其在量化金融新闻、社交媒体和企业披露中的市场情绪方面发挥了关键作用,从而提供了影响市场走势和投资决策的关键见解。此外,LLM在金融时间序列分析方面表现出潜力,包括预测市场趋势、检测异常和分类金融数据,尽管其功效仍有待讨论。这些模型旨在利用其深度学习架构捕捉金融数据集内复杂的时间依赖性和模式,以提高预测准确性和稳健性。LLM明显优于以往深度学习方法的一个最有前景的研究领域是其推理能力,使其不仅能拟合数据,还能模拟类似人类认知的推理过程。在金融推理中,LLM通过处理和综合来自不同来源的大量金融数据,支持财务规划、生成投资建议并协助决策。利用其模仿人类决策过程的能力,LLM进一步应用于基于Agent的建模。该应用将LLM的推理能力扩展到Agent与环境、市场和人之间的交互,使模拟市场行为、经济活动和金融生态系统的动态成为可能。

尽管取得了可喜的进展,但将LLM应用于金融领域也面临着几个挑战,例如回测中的前瞻性偏差、围绕机器人生成内容的法律问题、数据污染、信号衰减、推理速度、成本、不确定性估计、可解释性、伦理考量、安全性和隐私等。解决这些挑战对于确保LLM在金融应用中的道德和有效部署至关重要。基于普林斯顿和牛津的论文《A Survey of Large Language Models for Financial Applications: Progress,Prospects and Challenges》,我在这篇文章中展开了对于大模型金融应用的全面讨论。希望可以通过个人的视角与对论文的解读,能够帮助到行业内从事这项工作的朋友。

本文的主要内容和观点包括:

金融应用和实践见解的整体视角。希望能够基于综述而通过深入研究LLM在金融领域的应用,弥合了学术研究与实际应用之间的差距。这种整体视角确保了与研究人员和从业者的相关性,突出了LLM在不同金融任务中的变革潜力。

全面涵盖模型、数据和基准。深入研究了针对金融应用的特定LLM,分析了它们的架构、预训练方法和定制。我们还分析了数据集和基准,提供了宝贵的资源集合。

新颖的挑战和机遇。全面的提出了将LLM应用于金融领域的独特挑战,如前瞻性偏差、法律问题、数据污染和可解释性。我们探讨了潜在的解决方案和未来研究方向,为金融领域的进一步发展奠定了基础。

希望这项工作能够为当前LLM在金融中应用的现状提供全面概述,突出其进展、前景和挑战。通过对当前形势的详细调查,也希望它能够促进LLM在金融领域的采用和进一步发展,为创新解决方案和增强决策过程铺平道路。

2.1 GPT系列及其金融变体

2.1.1 GPT系列简介

2.1.2 Ploutos:基于GPT-4的金融预测框架

最近,Ploutos作为一个源自GPT-4的新型金融LLM框架被提出,用于可解释的股票走势预测。Ploutos由两个主要部分组成:PloutosGen和PloutosGPT。PloutosGen通过整合多模态数据来解决融合文本和数字信息的挑战,包括情感、技术和人工分析等不同视角的专家。另一方面,PloutosGPT使用后视镜提示(利用历史股票数据和专家分析指导模型)和动态令牌加权来生成准确且可解释的股票预测理由,从而解决传统方法中缺乏清晰度的问题。虽然Ploutos展示了预测准确性和可解释性的提升,但它受到潜在的专家选择偏差、计算复杂性和数据类型有限的限制。未来研究可能关注提高效率、扩展数据种类和减轻偏差,以进一步提升该框架的性能。

2.2 BERT系列及其金融变体

2.2.1 BERT模型简介

2018年,BERT(Bidirectional Encoder Representations from Transformers)及其深度双向架构掀起了NLP领域的革命浪潮,能够学习上下文表示。这一突破引发了若干领域特定变体的开发,特别是在金融领域。

2.2.2 FinBERT系列:专为金融领域设计的BERT变体

基于BERT的基础,FinBERT-19通过在金融文本上持续预训练BERT来增强其情感分析能力。次年,FinBERT-20通过从头开始进行特定领域的预训练,重点关注财务沟通和利用大规模金融语料库。2021年,FinBERT-21引入了混合领域预训练策略,利用通用和金融领域语料库(FinancialWeb、YahooFinance和RedditFinanceQA)。通过同时在通用和金融领域语料库上训练,FinBERT-21旨在捕获更广泛的语言知识和与金融文本挖掘相关的语义信息。这些FinBERT模型在各种金融下游任务中证明了其有效性,如情感分析、命名实体识别、问答和金融领域内的文本分类。

2.2.3 其他BERT变体:RoBERTa和Mengzi-BERTbase-fin

除了上述Fin-BERT模型,RoBERTa于2019年推出,是BERT的另一个变体。Mengzi-BERTbase-fin使用20GB金融新闻和研究报告进行训练,是RoBERTa的专门版本,专为金融应用而设计。

2.3 T5模型及其金融应用

2.3.1 T5模型简介

2019年,谷歌推出了Text-to-Text Transfer Transformer (T5),这是一个统一的框架,将每个文本处理任务视为"文本到文本"的问题。该模型采用编码器-解码器架构,并使用称为"跨度损坏"的自监督学习目标进行预训练。这涉及随机屏蔽输入序列中连续的文本跨度,并训练模型重构原始文本。

2.3.2 BBT-FinT5:面向中国金融领域的T5变体

在此基础上,专门为中国金融领域开发了BBT(Big Bang Transformer)-FinT5。该模型结合了知识增强型预训练方法,并基于BBT-FinCorpurs构建,这是一个大规模的金融语料库,包括企业报告、分析师报告、社交媒体和金融新闻等多个来源。BBT-FinT5受益于T5的文本到文本框架,使其能够处理金融领域内的语言理解和生成任务。然而,作为一个特定领域的模型,它在金融以外的通用NLP任务上的表现可能有限。BBT-FinT5可以针对各种金融应用进行微调,包括新闻分类、摘要、关系提取、情感分析和基于事件的问答。

2.4 ELECTRA模型及FLANG

2020年,ELECTRA引入了一种创新的生成器-鉴别器框架,用于预训练语言模型。该模型通过训练鉴别器区分真实和合成生成的令牌来提高效率。在此基础上,研究人员开发了FLANG,这是ELECTRA的专门变体,针对金融领域量身定制。FLANG结合了特定的调整,如选择性令牌屏蔽和跨度边界目标,以有效处理金融语言的复杂性。虽然FLANG擅长处理金融术语,在金融文档中的情感分析和实体识别任务上表现出色,但其专业化可能限制了它在非金融背景下的有效性,需要进一步微调。尽管存在这一局限性,FLANG在各种金融下游任务中展示了其价值。它能够精确分析市场报告,准确分类金融头条新闻,可靠地识别关键金融实体。

2.5 BLOOM模型及其金融变体

2022年,BLOOM作为一个基础的多语言LLM发布,拥有1760亿个参数。它在一个庞大的文本语料库上进行了预训练,包括46种自然语言和13种编程语言。BLOOM因其多样性和开源模型的可访问性而著称,支持多种语言。

2.5.1 BloombergGPT

从BLOOM衍生出了专注于金融应用的专门版本,包括BloombergGPT和XuanYuan 2.0。拥有500亿参数的BloombergGPT是为金融领域设计的,通过在彭博社的金融数据源上进行训练。该模型在特定金融任务上表现出更好的性能,同时保持了良好的整体能力。

2.5.2 XuanYuan 2.0

XuanYuan 2.0是为中国金融市场打造的一个大型开源中文金融聊天模型。它提出了一种新颖的混合调优策略,结合通用和金融特定数据,使模型在保留通用语言能力的同时,在特定领域任务(如金融咨询和市场分析)上表现出色。这一策略降低了之前知识灾难性遗忘的可能性,并提高了与金融相关任务的准确性。

2.6.1 Llama和Llama 2简介

2023年推出的Llama提供了灵活的模型尺寸选择,参数范围从7B到65B不等。尽管规模较小,但Llama在大多数基准测试中都优于GPT-3等更大的模型,这得益于它在公开数据集上的透明训练。

2.6.2 FinMA、Fin-Llama、FinGPT等金融变体

Llama的金融变体包括FinMA、Fin-Llama、Cornucopia中文版、Instruct-FinGPT和InvestLM,为各种金融任务提供专业功能。其中,基于LLaMA-65B和多样化投资相关数据集的InvestLM,提供了与尖端商业模型相媲美的投资建议。后来发布的Llama 2包括了对Llama的各种改进,如预训练语料库增加40%,上下文长度加倍,以及采用分组查询注意力机制以提高推理可扩展性。它的金融变体包括FinGPT、FinLlama和GreedLlama。特别是FinGPT是一个开源模型,专注于提供可访问和透明的资源,用于开发金融LLM。尽管训练数据相对BloombergGPT较少,但FinGPT声称为金融语言建模提供了更加可访问、灵活且经济的解决方案。

2.6.3 Llama 3及其潜在的金融应用

2024年4月,Meta推出了Llama 3,其8B和70B参数模型展示了最先进的性能和改进的推理能力,使其成为目前公开可用的最强大的LLM。LLM社区对此充满热情,我们预计很快会有更多基于Llama 3的金融LLM模型出现。

2.7 其他金融领域专用模型简介

除了上述模型,还有其他一些金融领域专用的LLM,如源自Mistral 7B的FinTral;基于Qwen 1.5-7B聊天模型的SilverSight;使用Baichuan-13B作为主干的DISC-FinLLM;基于InternLM-7B的CFLLM;以及用于金融图表分析、基于LLaVA的FinVIS-GPT。这些特定领域的LLM利用海量金融数据集和先进的训练技术,提供比通用领域模型更精确和具有上下文感知能力的金融分析。随着这一领域研究的不断进展,我们期待着更加复杂的金融LLM的开发,它们可以改变金融行业的各个领域,包括投资策略、风险管理、预测和客户服务。然而,认识并运用这些模型的局限性和潜在偏差至关重要,需要谨慎地将其与人类专业知识和判断相结合。

零样本学习和微调是LLM应用中两种不同的适应方法。零样本(或少样本)学习是指模型根据其预先存在的知识和泛化能力,正确预测或执行它没有明确训练过的任务的能力。另一方面,微调涉及在特定数据集或特定任务上调整预训练模型,以提高其在该任务上的准确性和性能。

当特定领域的准确性至关重要、需要适应实时变化或定制和隐私是关键考虑因素时,微调更受青睐。在实践中,将与金融相关的文本数据集成是微调LLM的常见方法。Araci开发了FinBERT,这是BERT语言模型的定制版本,通过在综合金融数据集(包括新闻、文章和推文)上进行扩展预训练,并采用战略性微调方法实现。FinBERT在金融相关文本分析领域树立了新的基准,超越了该领域早期的深度学习方法。

为了提高微调效率,已经提出了几种技术。指令调优是一种语言模型的微调方法,模型被训练为遵循特定指令,不仅可以提高目标任务的性能,还可以增强模型的零样本和少样本学习能力,因此在各种金融应用和模型中很受欢迎。Zhang等人提出了一个指令调优的FinGPT模型,通过采用指令调优来增强LLM的金融情感分析能力,该方法将一小部分有监督的金融情感数据转化为指令数据,从而提高了模型的数值敏感性和上下文理解能力。此外,Zhang等人将指令调优的LLM与检索增强模块相结合,这是一种通过从外部来源检索相关信息来补充输入,从而增强语言模型的技术,以丰富上下文来提高模型的预测性能。除了指令调优,人们还将低秩自适应(LoRA)或量化LLM应用于金融任务的更有效适应,如FinGPT、FinGPT-HPC和基于Llama的模型。

另一种流行的方法涉及考虑更小的模型,因为在当今的机器学习领域,模型的能效和轻量化至关重要。Rodriguez Inserte等人证明,通过在金融文档和指令上进行微调,较小的LLM可以实现与较大模型相当或更优的性能。Deng等人提出了一个案例研究,利用LLM在Reddit数据上进行半监督的金融情感分析,其中LLM通过上下文学习和思维链推理生成弱情感标签,然后用于训练一个更小的生产用模型,在最少人工标注的情况下实现了具有竞争力的性能。

尽管预训练和微调允许这些模型适应各种应用的特定语言特征和风格,但当标记数据有限、需要快速部署或模块化开发和可解释性是优先考虑的因素时,更倾向于零样本学习。LLM的零样本和少样本能力凸显了它们的效率,允许直接应用而无需进行大量特定数据集训练。这种效率源于LLM所训练的海量数据集的迁移学习,以及它们在信息处理过程中产生新见解或解决意外问题的新兴能力。这些特点显著扩大了它们在各个领域的用途,而无需进一步训练。例如,Steinert和Altmann探索了GPT-4在2017年使用微博消息预测苹果和特斯拉当日股价走势的零样本能力,并通过与BERT进行比较,强调了提示工程在从GPT-4中提取复杂情感用于金融应用方面的重要性。

参考论文:arXiv:2406.11903v1

END

为助力更多企业在人工智能的浪潮中乘风破浪,“AI+研发数字峰会(AiDD)”应运而生,旨在帮助更多企业借助AI技术,使计算机能够更深入地认知现实世界,推动研发全面进入数智化时代。北京站即将于8月16-17日盛大启幕!

点击下方“阅读原文”或扫描下方海报二维码了解更多峰会信息。